Imagem: cottonbro studio

TARCÍSIO PERES*

Com o advento do “admirável mundo novo” da IA, o déficit linguístico é muito mais grave e urgente do que a sofrência matemática

1.

No início dos anos 2000, a chegada de buscadores como o Google transformou sobremaneira a forma de pesquisar informações. Antes disso, encontrar conteúdo confiável envolvia longas buscas em livros, bibliotecas e acervos físicos, dependia de conhecimento prévio de diretórios de sites ou exigia a aquisição de enciclopédias em CD-ROM. A adoção de algoritmos de ranqueamento, como o PageRank, permitiu obter resultados mais relevantes em poucos segundos, liberando os usuários de processos morosos e abrindo caminho para um acesso mais rápido e direto a uma infinidade de temas.

O crescimento da banda larga e a maior capilarização das redes também contribuíram para essa democratização do conhecimento, uma vez que reduziram drasticamente os custos de acesso à internet e ampliaram o alcance dos buscadores. Com isso, o hábito de “ir até a biblioteca” ou depender de acervos físicos deu lugar a uma simples pesquisa online, cada vez mais acessível até em regiões antes excluídas do universo digital. Esse fenômeno acelerou a disseminação de conteúdos variados – desde explicações sobre assuntos escolares até artigos científicos de ponta – e tornou o processo de aprendizado muito mais dinâmico e ágil para estudantes, profissionais e curiosos de todas as áreas.

Nos últimos anos, contudo, a monetização crescente dessas ferramentas modificou o cenário de pleno acesso à informação. Muitos buscadores passaram a privilegiar propagandas e links patrocinados, obrigando o usuário a percorrer diversas páginas antes de chegar aos resultados orgânicos que realmente respondam às suas perguntas. Esse movimento comercial afeta a neutralidade e a função pedagógica do buscador, pois prioriza o lucro em detrimento do conhecimento direto, fazendo com que a promessa inicial de democratização seja parcialmente ofuscada pelo interesse econômico.

Nesse ínterim, a disseminação da inteligência artificial generativa tem promovido um fenômeno histórico peculiar, ao resgatar, por meio da tecnologia, duas ideias inicialmente propostas no século XIX por Francis Galton. Conhecido por seus estudos pioneiros em genética e antropometria, Francis Galton criou o conceito de “regressão à média” ao notar, por exemplo, que filhos de pais muito altos frequentemente tinham uma estatura mais próxima à média populacional, em vez de manter a altura excepcional dos progenitores. Esse fenômeno ilustra que características extremas tendem, naturalmente, a retornar a níveis intermediários com o passar das gerações.

Eugenia refere-se a um conjunto de ideias e práticas que visam “melhorar” características genéticas de populações humanas por meio de seleção e exclusão de determinados grupos ou indivíduos. Surgida oficialmente com o trabalho de Francis Galton, a eugenia ganhou força em diferentes países no início do século XX, especialmente por meio de políticas de esterilização forçada, leis de imigração restritivas e outras medidas discriminatórias.

Essas práticas, justificadas sob a alegação de aprimorar a “qualidade” da população, resultaram em graves violações de direitos humanos e influenciaram tragicamente regimes totalitários, como o nazismo, que levou tais ideias ao extremo com programas de extermínio em massa. Atualmente, a eugenia é amplamente condenada pela comunidade científica e pela sociedade em geral, tanto do ponto de vista ético quanto científico, reconhecendo-se os perigos e injustiças inerentes a qualquer tentativa de manipular a diversidade genética humana de forma coercitiva. Francis Galton se tornou famoso por defender ideias eugênicas, sustentando que a população humana poderia ser aprimorada artificialmente pela seleção dos indivíduos considerados mais aptos.

Hoje, ainda que de maneira menos evidente e mais sutil, é possível perceber um processo análogo no funcionamento e utilização da inteligência artificial generativa. Essa tecnologia opera por meio da interação direta com os usuários, produzindo resultados (textos, respostas ou conhecimentos) a partir das instruções iniciais, chamadas de prompts. Estes são os comandos ou as perguntas feitas pelos usuários ao software de inteligência artificial (tipicamente um chat). Eis um detalhe técnico fundamental: a qualidade das respostas obtidas depende diretamente da clareza, precisão, complexidade e abrangência desses comandos iniciais.

2.

Quando indivíduos com pouco êxito em construções e articulações linguísticas e acanhada erudição – como, por exemplo, analfabetos funcionais – utilizam os chats com inteligência artificial, tendem a formular prompts mais vagos, imprecisos ou simplificados. Como a Inteligência artificial necessita de informações claras para gerar respostas qualificadas, esses prompts pouco estruturados resultam em respostas superficiais e limitadas, que raramente exploram a riqueza potencial de conhecimentos armazenados na base de dados do sistema.

Nesses casos, a inteligência artificial devolve ao usuário um resultado mediano, um pouco melhor do que o usuário conseguiria sozinho, porém restrito e sem grande profundidade. Essa dinâmica é semelhante à ideia da regressão à média formulada por Francis Galton: os usuários que estão muito abaixo da média acabam melhorando seu repertório ligeiramente, mas ficam estacionados em um nível intermediário. Esse lugar mediano, limítrofe ou medíocre, nos lembra o “Mediocristão” definido por Nassim Taleb.

Ademais, a inteligência artificial, ao tentar reproduzir as intenções e preferências do usuário, pode gerar respostas incorretas ou imprecisas, mesmo que disponha de um extenso acervo de dados confiáveis. Prompts saturados de pressupostos falhos, vieses ou ambiguidades conduzem o sistema a replicar tais distorções, pois o objetivo final é satisfazer a demanda formulada, ainda que isso resulte em conteúdos precários ou factualmente questionáveis. Nesse processo, a tecnologia reforça possíveis equívocos e consolida crenças equivocadas, limitando a profundidade das informações produzidas e inviabilizando o papel educativo que se espera de uma ferramenta de grande alcance.

Por exemplo, um usuário que se baseia em premissas errôneas e escreve algo como “Foi Dom Pedro II quem descobriu o Brasil em 1500, certo?” pode induzir a inteligência artificial a produzir uma resposta que corrobore essa informação historicamente equivocada, pois a formulação do prompt conduz o sistema a validar a pergunta em vez de corrigi-la de modo incisivo. Mesmo que a Inteligência artificial tenha acesso a registros confiáveis que indicam Pedro Álvares Cabral como responsável pela chegada dos portugueses em 1500, a construção ambígua da solicitação pode resultar em um texto final que repita ou suavize a distorção inicial, evidenciando como a ferramenta reflete as lacunas de conhecimento e as concepções equivocadas do usuário. Neste caso, o acrônimo IA pode ser intercambiado para “Idiota Automatizado”. “Shit in, shit out”, bradariam os entusiastas tecnocratas de plantão.

Por outro lado, usuários que já possuem boa formação cultural, domínio da linguagem e capacidade argumentativa são capazes de formular prompts mais precisos, detalhados e intelectualmente sofisticados. Por exemplo, enquanto um usuário com pouco domínio da linguagem pode perguntar à inteligência artificial algo como “quem descobriu o Brasil?”, um usuário mais preparado culturalmente poderia formular uma questão mais rica e contextualizada, como “de que maneira o processo de colonização portuguesa influenciou na formação cultural e social do Brasil contemporâneo?”.

Esse segundo prompt gera respostas mais completas, detalhadas e relevantes, pois fornece à Inteligência artificial uma orientação clara sobre o nível de profundidade desejado. Como resultado, esses usuários recebem conteúdos mais ricos e elaborados, capazes de ampliar ainda mais seu repertório intelectual. Estão, portanto, em um lugar privilegiado ou “Extremistão” em oposição ao Mediocristão talebiano. Há, inclusive, um novo mercado de “venda de prompts” dos mais favorecidos aos menos afortunados.

Dessa forma, o que acontece é que usuários já privilegiados culturalmente conseguem potencializar ainda mais suas vantagens, enquanto aqueles que enfrentam dificuldades prévias alcançam melhorias apenas marginais, ou até intensificam suas deficiências no pior caso. Essa lógica exemplifica perfeitamente o chamado “efeito Mateus”, extraído do Evangelho de Mateus, segundo o qual “àquele que já tem, mais será dado, e terá em abundância; enquanto ao que não tem, até o pouco que possui lhe será retirado”. Aplicado ao contexto da inteligência artificial, os usuários culturalmente preparados acumulam ainda mais conhecimento e aprofundam suas competências, enquanto usuários culturalmente frágeis avançam pouco e permanecem estacionados em níveis básicos ou medianos.

3.

Ao mencionarmos os resultados dos estudantes brasileiros no Programa Internacional de Avaliação de Estudantes (PISA) já é clichê destacar o desempenho sofrível em matemática. Não podemos esquecer, no entanto, que em leitura, o desempenho médio dos estudantes brasileiros foi de 410 pontos, inferior à média da OCDE de 476 pontos (dados da última edição, em 2022). Metade dos estudantes brasileiros não alcançou o nível básico de proficiência em leitura, enquanto nos países da OCDE essa porcentagem foi de 26%. Como reforçaremos aqui, com o advento do “admirável mundo novo” da IA, o déficit linguístico é muito mais grave e urgente do que a sofrência matemática.

A ideia segundo a qual o domínio da linguagem precede e condiciona os demais campos do saber humano não constitui uma inovação recente, tendo sido amplamente debatida e sustentada por diferentes pensadores ao longo da história da filosofia. Entre os autores clássicos que defendem essa primazia destaca-se Aristóteles, para quem a linguagem era a base fundamental da lógica e, portanto, de todo pensamento racional. Ele argumentava que a compreensão rigorosa das palavras e sua correta aplicação constituíam o alicerce indispensável de qualquer investigação intelectual subsequente.

Essa perspectiva foi posteriormente reforçada e reinterpretada na Idade Média, sobretudo por autores escolásticos como Tomás de Aquino. Para Aquino, o domínio da linguagem era visto como uma etapa essencial ao conhecimento da verdade, uma vez que o raciocínio filosófico e teológico dependia da clareza conceitual e linguística. Sem domínio sobre o discurso e sobre as definições precisas, o pensamento ficaria preso em confusões terminológicas e ambiguidades conceituais. Na escolástica medieval, a dialética – arte da discussão e da argumentação baseada na linguagem – foi considerada prioritária, antecedendo o próprio desenvolvimento de disciplinas matemáticas ou científicas, pois garantia a fundamentação lógica e a solidez necessária a qualquer saber.

Já na modernidade, essa primazia da linguagem é retomada por autores como Wilhelm von Humboldt, que enfatizava o papel crucial da linguagem na construção da realidade humana. Humboldt acreditava que a língua molda o pensamento e a percepção da realidade, determinando o modo como o indivíduo compreende e interage com o mundo. Essa ideia antecipou abordagens filosóficas e epistemológicas posteriores, que enfatizariam a importância das estruturas linguísticas na configuração das formas de pensamento humano.

No século XX, Ludwig Wittgenstein consolidou ainda mais essa visão ao defender que os limites da linguagem representam os próprios limites do mundo inteligível. Wittgenstein sustentava que muitos problemas filosóficos decorriam de confusões linguísticas, indicando que a clareza conceitual era condição para resolver dilemas fundamentais em diversas áreas do conhecimento. Dessa maneira, fica evidente que a ideia segundo a qual a linguagem precede outros saberes e define o horizonte intelectual dos indivíduos tem raízes históricas profundas, consolidada por diferentes tradições filosóficas muito antes de sua apropriação contemporânea.

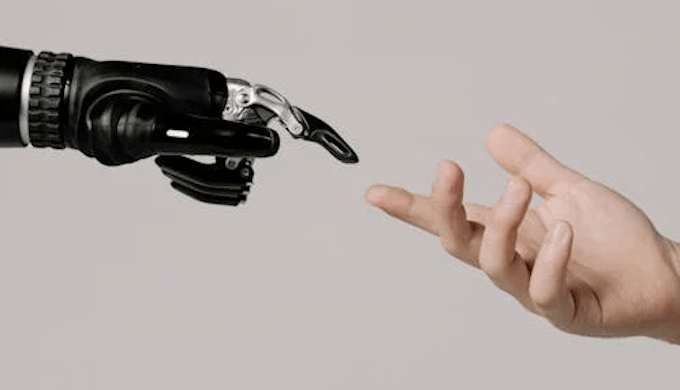

Nesse sentido, cria-se uma situação paradoxal: uma tecnologia frequentemente apontada como capaz de democratizar o conhecimento acaba funcionando como uma ferramenta que aprofunda desigualdades. Sem necessidade de coerção ou intervenção explícita, a inteligência artificial generativa efetua uma seleção cognitiva e cultural indireta, semelhante aos ideais originais defendidos por Francis Galton, privilegiando indivíduos que já estão socialmente favorecidos pela qualidade superior dos comandos iniciais que são capazes de formular.

*Tarcísio Peres é professor de ciências das Faculdades de Tecnologia do Estado de São Paulo. Autor, entre outros livros, de Lucrando com os tubarões: as armadilhas da bolsa e como usá-las a seu favor (Novatec Editora) [https://amzn.to/3TKlVwU]

Nenhum comentário:

Postar um comentário

12